用 ollama 來玩免費開源語言模型

文章摘要

在 ChatGPT 問世後,大多數科技大廠都推出了自家的語言模型,而有不少開源模型出現。我們可以透過 OLLAMA 在自己的電腦中,建立私有的語言模型服務,並且能夠自由控制和定制模型的性能和功能。

簡介

Ollama 是一個支持 Llama 3 、 Mistral 、 Gemma 、 Phi 3 等大型語言模型的框架,適用於 macOS、Windows、Linux 和 Docker。

下載

下載位址: | MAC | Linux | Windows |

Windows / MacOS 安裝

依安裝精靈進行即可

Linux 在透過 curl 安裝

curl -fsSL https://ollama.com/install.sh | sh

Docker 安裝

docker pull ollama/ollama

快速開始

-

運行

Llama 3模型ollama run llama3 -

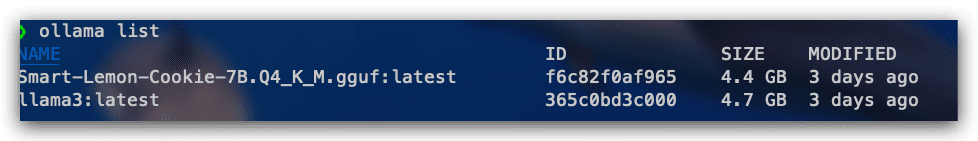

查看所有支持的模型:

ollama list

-

拉取模型

ollama pull llama3 -

複製模型

ollama cp llama3 my-model -

刪除模型

ollama rm llama3

利用 REST API

產生回應

curl http://localhost:11434/api/generate -d '{

"model": "llama3",

"prompt":"Why is the sky blue?"

}'

使用一個模型聊天

curl http://localhost:11434/api/chat -d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'

Open WebUI 圖型化介面

由於 ollama 是開源,所以有不少開源軟體,幫 ollama 製作圖型化介面。而目前站長推薦使用 Open WebUI。Open WebUI的操作介面和 chatGPT 很接近,是運行在 docker的環境下。

只要安裝好Docker的環境後和ollama的服務後,只要執行下列指令就可以開始玩ollama了

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

使用 VScode 插件

除了用 Open WebUI 之外,有在使用 VScode 編輯器,可以安裝下面插件,就可使用 ollama

插件網址: 插件官網

X